Data Center: così l’AI sta rimodellando i progetti di nuova generazione. La sfida degli specialisti dei data center è costruire oggi l’infrastruttura necessaria per l’intelligenza artificiale generativa.

Contenuto a cura di Bob Wagner, Senior Business Development Manager presso Panduit.

Quando ChatGPT è stato lanciato nel novembre 2022, ha innescato la rivoluzione dell’intelligenza artificiale (IA), che sta trasformando ogni settore e cambiando il modo in cui lavoriamo. Tra le sue numerose capacità, l’intelligenza artificiale offre la possibilità di migliorare l’efficienza e la produttività nel settore manifatturiero, sviluppare progressi nella ricerca medica e migliorare attività creative, come la produzione di contenuti, immagini e video.

L’intelligenza artificiale viene solitamente suddivisa in due categorie principali: generativa e predittiva. L’IA generativa (GenAI) utilizza i dati esistenti come base per creare nuovi contenuti originali, come discorsi conversazionali, articoli scritti, immagini o nuovi prodotti. L’intelligenza artificiale predittiva, come suggerisce il nome, viene utilizzata per fare previsioni basate sulle tendenze dei dati per migliorare il processo decisionale. GenAI è spesso utilizzata nel marketing, nel design e nella medicina. L’IA predittiva viene utilizzata nelle analisi di mercato, nella manutenzione preventiva e nella finanza.

I data center non solo ospitano apparecchiature di intelligenza artificiale, ma possono anche trarre vantaggio da questi potenti sistemi. Gli algoritmi avanzati e le capacità di apprendimento automatico dell’intelligenza artificiale predittiva possono analizzare enormi quantità di dati in tempo reale, consentendo ai data center di diventare sempre più intelligenti e adattivi. Saranno in grado di anticipare e affrontare potenziali problemi prima che si verifichino, garantendo la massima operatività e affidabilità: ciò che i clienti dei data center apprezzano di più!

Si prevede che l’intelligenza artificiale contribuirà con 15,7 trilioni di dollari all’economia globale entro il 2030 (fonte: PwC)

Le nuove GPU alimentano la crescita dell’intelligenza artificiale e molti cambiamenti

Negli ultimi eventi internazionali di NVIDIA GTC e OFC (Optical Fiber Communication Conference and Exhibition) a marzo e DC World ad aprile, l’intelligenza artificiale ha dominato la maggior parte delle conversazioni. NVIDIA GTC ha fornito uno sguardo approfondito sulla tecnologia GPU più recente e potente, OFC ha introdotto le ultime novità in fatto di reti ad alta velocità e DC World ha fornito una panoramica su come tutto ciò influirà sui requisiti dei data center.

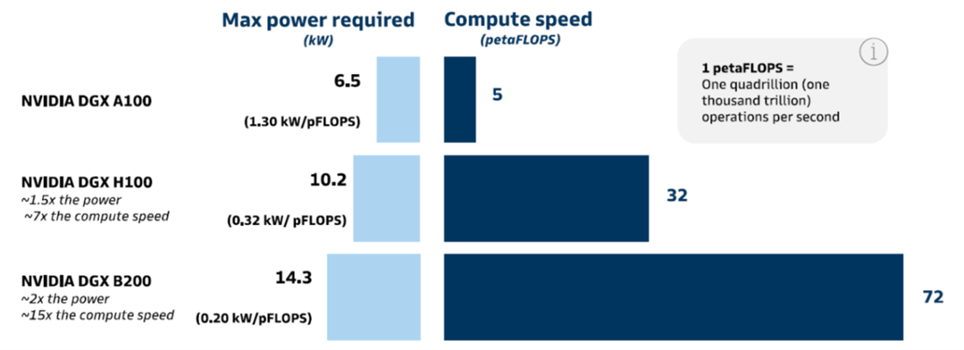

Dopo aver introdotto per diversi anni una nuova GPU ogni due anni, NVIDIA lo ha fatto di nuovo nel 2024 con il nuovo processore Blackwell che offre un miglioramento significativo rispetto ai suoi predecessori. La figura seguente mostra sia l’aumento di potenza che l’aumento della velocità di elaborazione per tre diversi server NVIDIA ciascuno con 8 GPU.

Anche se potrebbe volerci del tempo prima che i prodotti che utilizzano Blackwell vengano presentati sul mercato, ha già dato alle aziende di data center un’idea di che tipo di infrastruttura dovranno installare. Un rack completo di quattro DGX B200 avrà bisogno di 60 kW, ma per il SuperPod NVL72 di fascia alta che utilizza il Superchip GB200 servirà fino a 120 kW e richiederà un raffreddamento a liquido diretto su chip. NVIDIA ha anche annunciato che la sua prossima GPU chiamata Rubin, il cui rilascio è potenzialmente previsto nel 2026, sarà progettata per ottimizzare l’efficienza energetica.

Al DC World, Ali Fenn, presidente di Lancium, ha affermato che “l’intelligenza artificiale costituirà la più grande formazione di capitale della storia” e ha osservato che sarà l’offerta di energia, più della tecnologia GPU, a determinare la velocità con cui potrà crescere. Esistevano già preoccupazioni sulla fornitura di energia prima dell’avvento dell’intelligenza artificiale, quando un rack medio necessitava solo di 10 kW, ma ha assunto un senso di urgenza completamente nuovo ora che la potenza del rack potrebbe richiedere 12 volte di più.

Esigenze di raffreddamento e densità di cablaggio tra le sfide da risolvere

L’aumento della domanda di capacità di calcolo nei data center, causata dalle applicazioni di intelligenza artificiale, sta accelerando la necessità di opzioni di raffreddamento a liquido. Ciò era già evidente nell’area espositiva all’evento DC World, dove erano presenti oltre 10 aziende di raffreddamento a liquido, molte delle quali erano start-up con meno di due anni. Sebbene esistano opinioni divergenti su quando sia necessario il raffreddamento a liquido, si ritiene comunemente che dovrebbe essere utilizzato quando la potenza del rack è superiore a 40 kW. L’aggiunta di sistemi di raffreddamento a liquido a un data center esistente non è banale e richiede anche di dover avere esperti di idraulica nello staff.

Entro il 2025, il 10% dell’energia totale dei data center sarà utilizzata per l’intelligenza artificiale (fonte: New York Times)

Per connettere tutte le GPU per creare un cluster (o pod) necessario per l’intelligenza artificiale su larga scala, sono necessari cavi in fibra e ricetrasmettitori ottici ad alta velocità. Con un massimo di 8 GPU per server, ciascuna in esecuzione a velocità dati fino a 800G, molti data center vedranno un aumento di 4 volte del numero di cavi in fibra. Ciò a sua volta aumenta la congestione nei percorsi dei cavi e spesso porta alla necessità di percorsi più ampi, come quelli larghi 24″ o 36″, e con più livelli se lo spazio del soffitto lo consente.

Inoltre, i data center dovranno essere progettati per garantire scalabilità e flessibilità per gestire i carichi di lavoro dell’intelligenza artificiale. Le reti ad alta velocità e a bassa latenza sono fondamentali per un’efficiente elaborazione dei dati IA, insieme a robusti sistemi di archiviazione e tecniche avanzate di gestione dei dati. Gli operatori dei data center saranno inoltre sottoposti a una pressione ancora maggiore per mitigare l’impatto ambientale delle loro operazioni e l’uso di fonti energetiche rinnovabili sarà un must. A causa delle limitazioni della rete elettrica in molte aree del mondo, anche l’energia nucleare sta ricevendo una seria attenzione come modo per ridurre l’impronta di carbonio aggiungendo allo stesso tempo un’ulteriore fonte di energia. Scalabilità, flessibilità, sicurezza e sostenibilità ambientale sono tutti fattori essenziali da considerare quando si progettano e gestiscono i data center IA.

I nuovi data center IA richiederanno nuovi edifici

L’intelligenza artificiale sta interessando tutti i mercati, ma il suo impatto maggiore viene avvertito da coloro che operano nel settore della costruzione di data center. La combinazione di tutti questi cambiamenti nei requisiti ha convinto molte aziende di data center che il retrofitting dei data center esistenti non è sempre fattibile. Dovranno essere costruiti nuovi edifici situati in aree con energia elettrica abbondante e poco costosa. I nuovi data center IA saranno costruiti appositamente con sistemi di raffreddamento a liquido (acqua o fluido dielettrico), percorsi di cablaggio più ampi e pavimenti in cemento più spessi necessari per ospitare le apparecchiature IA più pesanti.

Nonostante gli immensi vantaggi dell’intelligenza artificiale, la transizione necessaria per implementarla nei data center presenta molte sfide:

• Più energia per accompagnare la crescita dei dati

• Sistemi di raffreddamento innovativi

• Aumento fino a 4 volte della quantità di fibre utilizzate per collegare server e switch

• Percorsi aerei più ampi

• Progetti per aggiungere capacità senza interrompere le reti di cablaggio esistenti

• Migliore sostenibilità

In termini più semplici, i proprietari dei data center devono essere in grado di gestire più cose: più cavi in fibra, più spazio per i percorsi, più calore e, soprattutto, più energia. Nonostante questi ostacoli, è un momento entusiasmante per operare nel settore dei data center poiché la costruzione di nuovi data center è ai massimi storici e non è ancora in grado di tenere il passo con la domanda.

In questa infografica sull’intelligenza artificiale è possibile consultare le statistiche più importanti che stanno rimodellando il panorama dei data center IA.